我们提供安全,免费的手游软件下载!

在先前的操作中,我们曾经使用 angthingLLM + Ollama 来实现本地大模型的部署,具体详情请参见: https://www.cnblogs.com/jokingremarks/p/18151827 。

然而,这次我们决定使用兼容性更好的 Open WebUI。

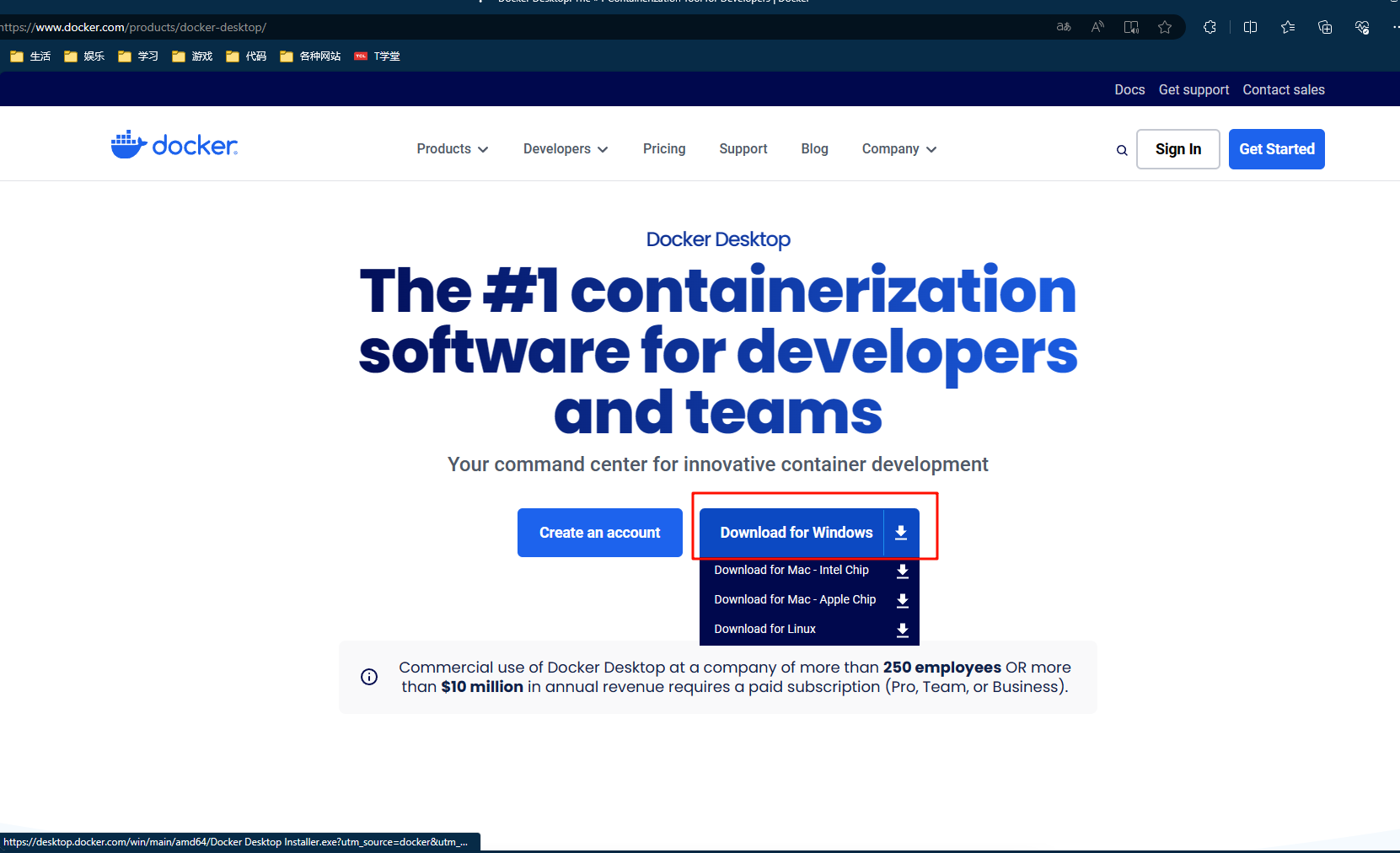

出于方便考虑,我们选择在 Windows 系统上安装 Docker:

可前往 Docker 官网下载所需的安装程序:

https://www.docker.com/products/docker-desktop/

下载完成后,根据所选的操作系统版本进行安装。

接着,启动虚拟化(Microsoft Hyper-V)。

具体操作步骤可参考: https://www.cnblogs.com/jokingremarks/p/18156334

然后,直接打开安装程序,按照提示一路进行安装即可。

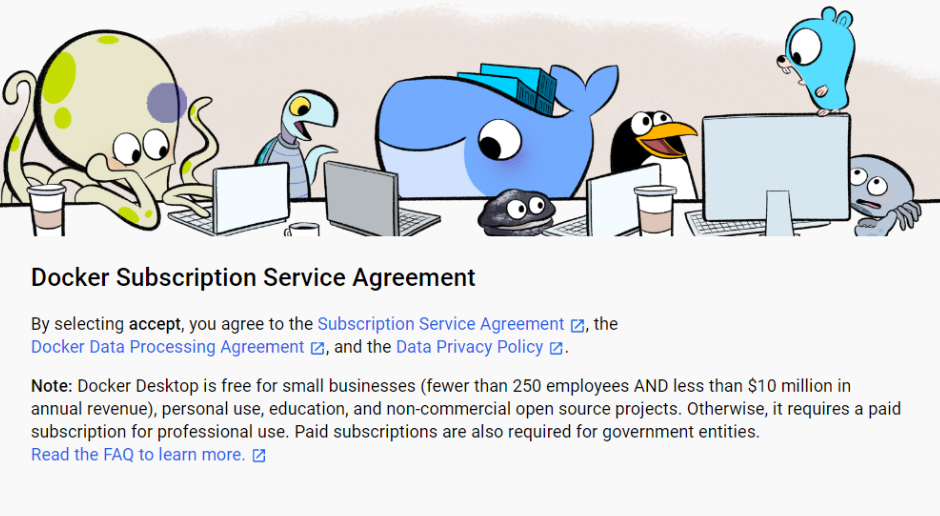

重启电脑后,即可看到以下界面:

点击 "Accept",然后默认设置即可进入。

如果遇到无法进入的情况,界面一直提示 "Docker Engine stopped",可参考以下链接获取解决方法:

https://www.cnblogs.com/jokingremarks/p/18156334

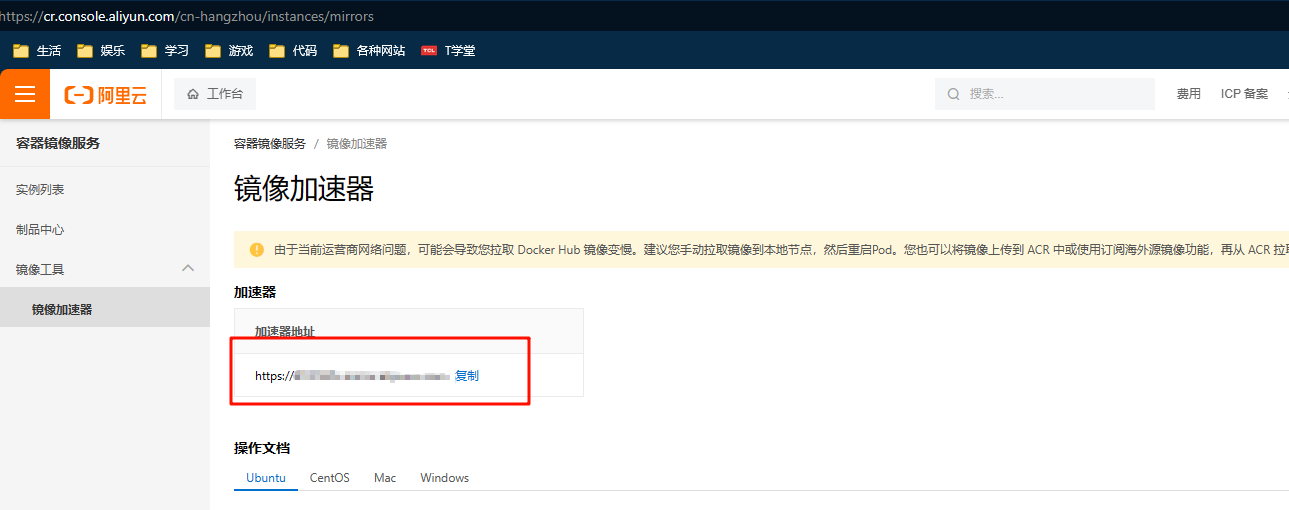

建议配置阿里云镜像,否则拉取速度可能会较慢:

阿里云镜像链接:

https://cr.console.aliyun.com/cn-hangzhou/instances/mirrors

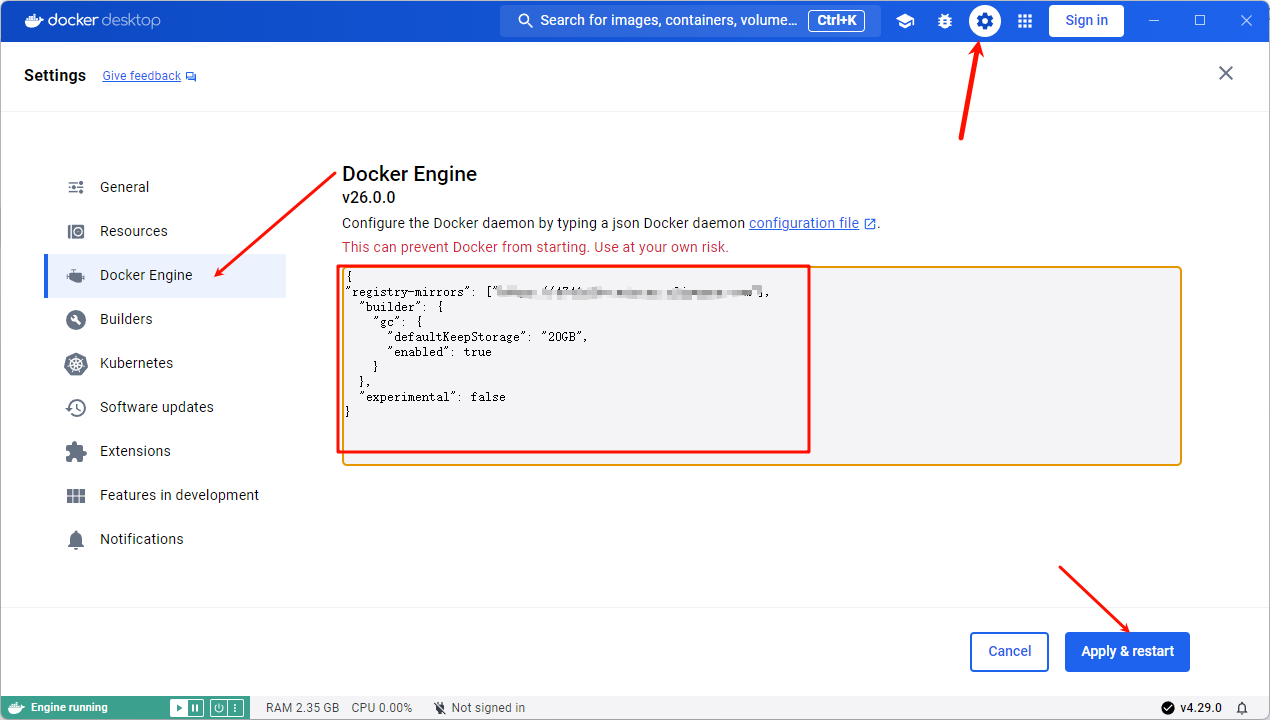

复制这个链接,打开 Docker Desktop,找到 "设置",在 "Docker Engine" 中输入以下内容:

"registry-mirrors": ["复制的网址"]

然后点击 "Apply & Restart" 以完成配置。

Open WebUI 的 GitHub 地址: https://github.com/open-webui/open-webui?tab=readme-ov-file#how-to-install-

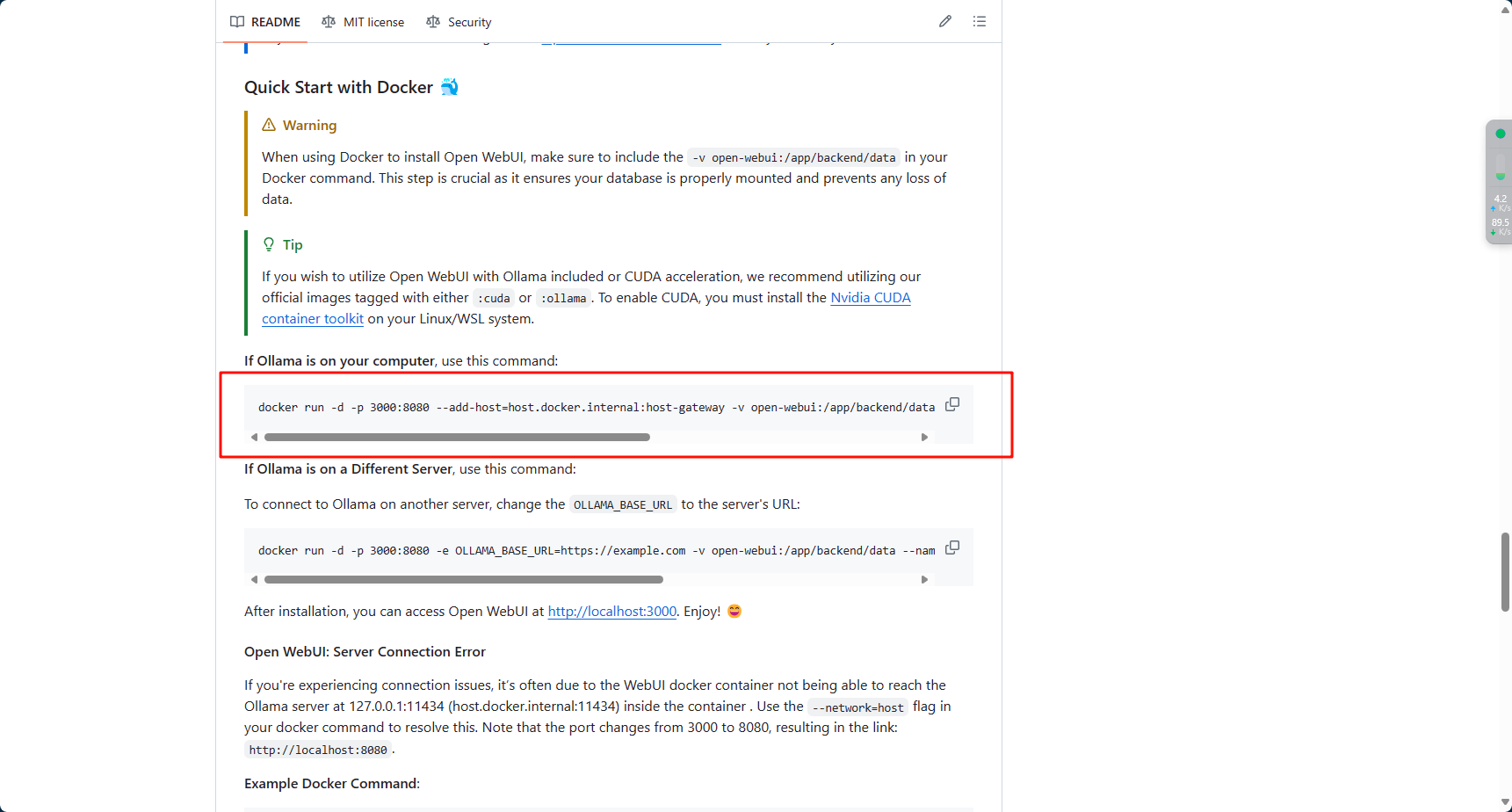

在 "README" 区域找到相关信息:

由于我们是在本地安装 Ollama,因此可以直接在 PowerShell(管理员权限)中执行以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

等待进度条走完即可。

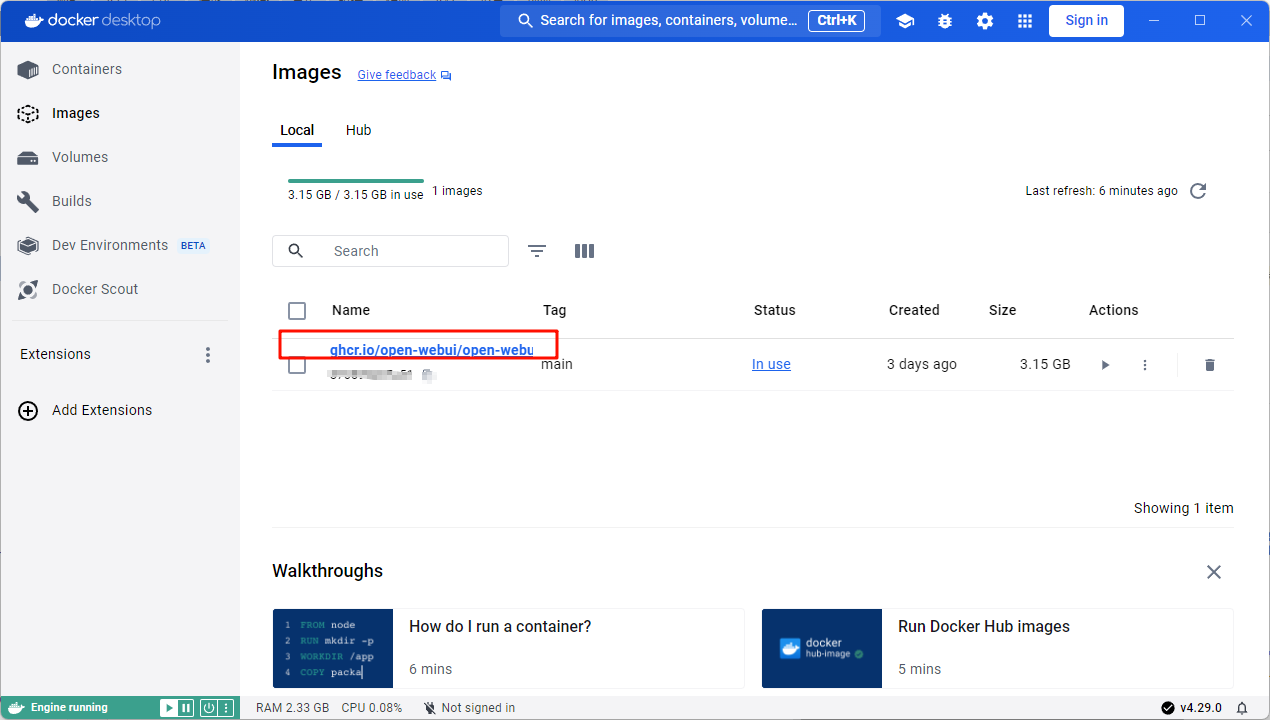

此时,可以在 Docker Desktop 的 "Images" 中看到已下载的 Open WebUI。

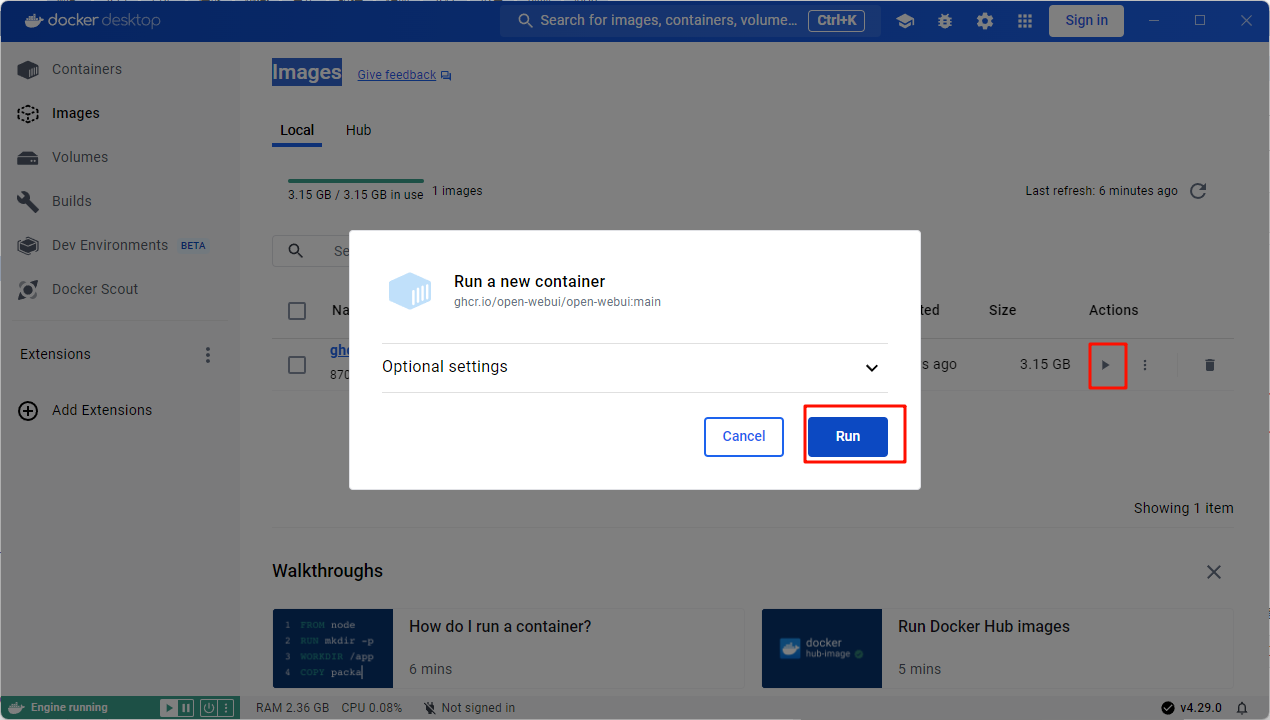

启动速度较快,点击 "Run"。

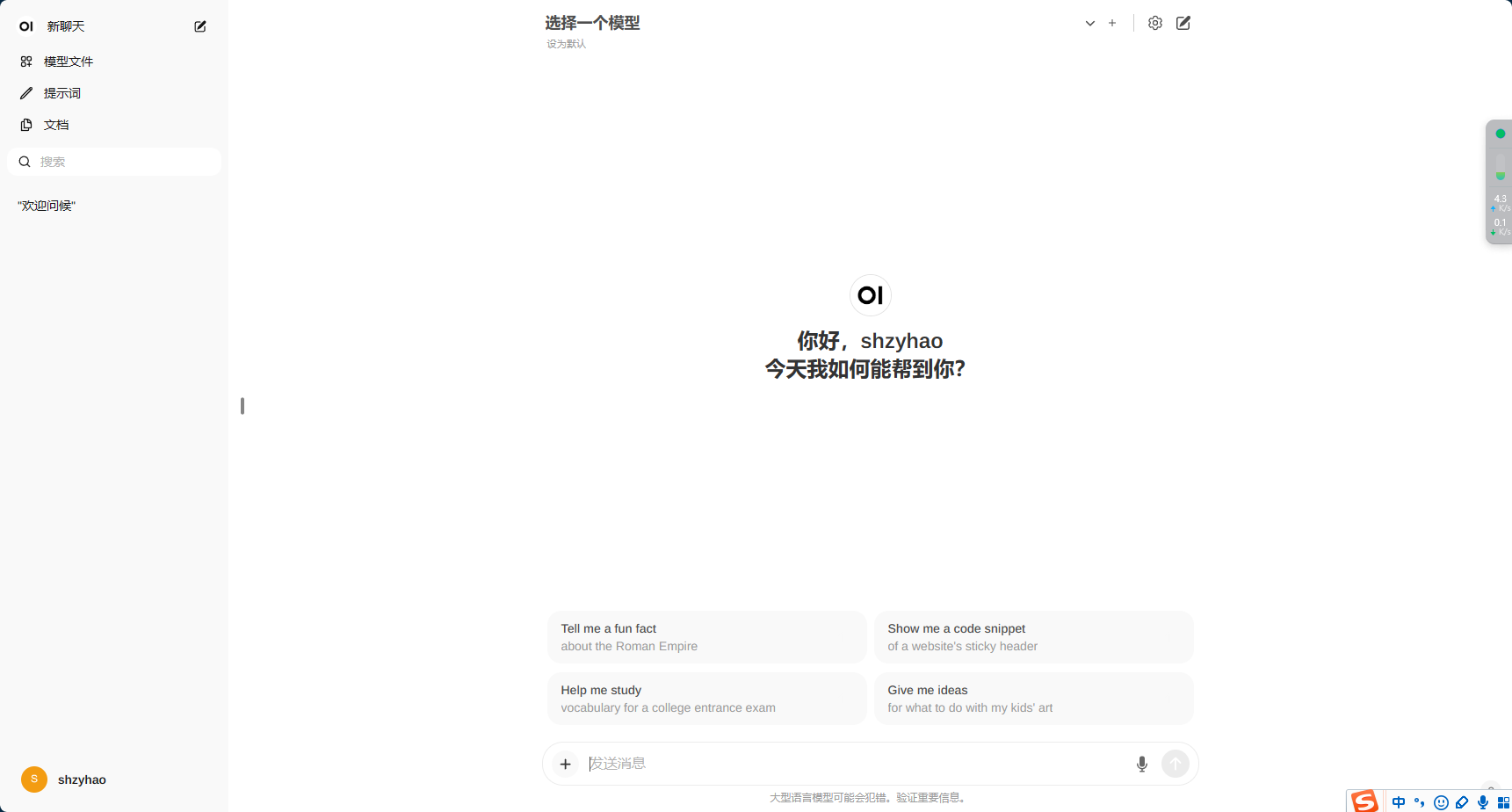

等待加载,在浏览器中输入:

http://localhost:3000/

即可进入。

初次进入时需要注册,由于是本地环境,无需验证码等操作,填写正常信息即可。

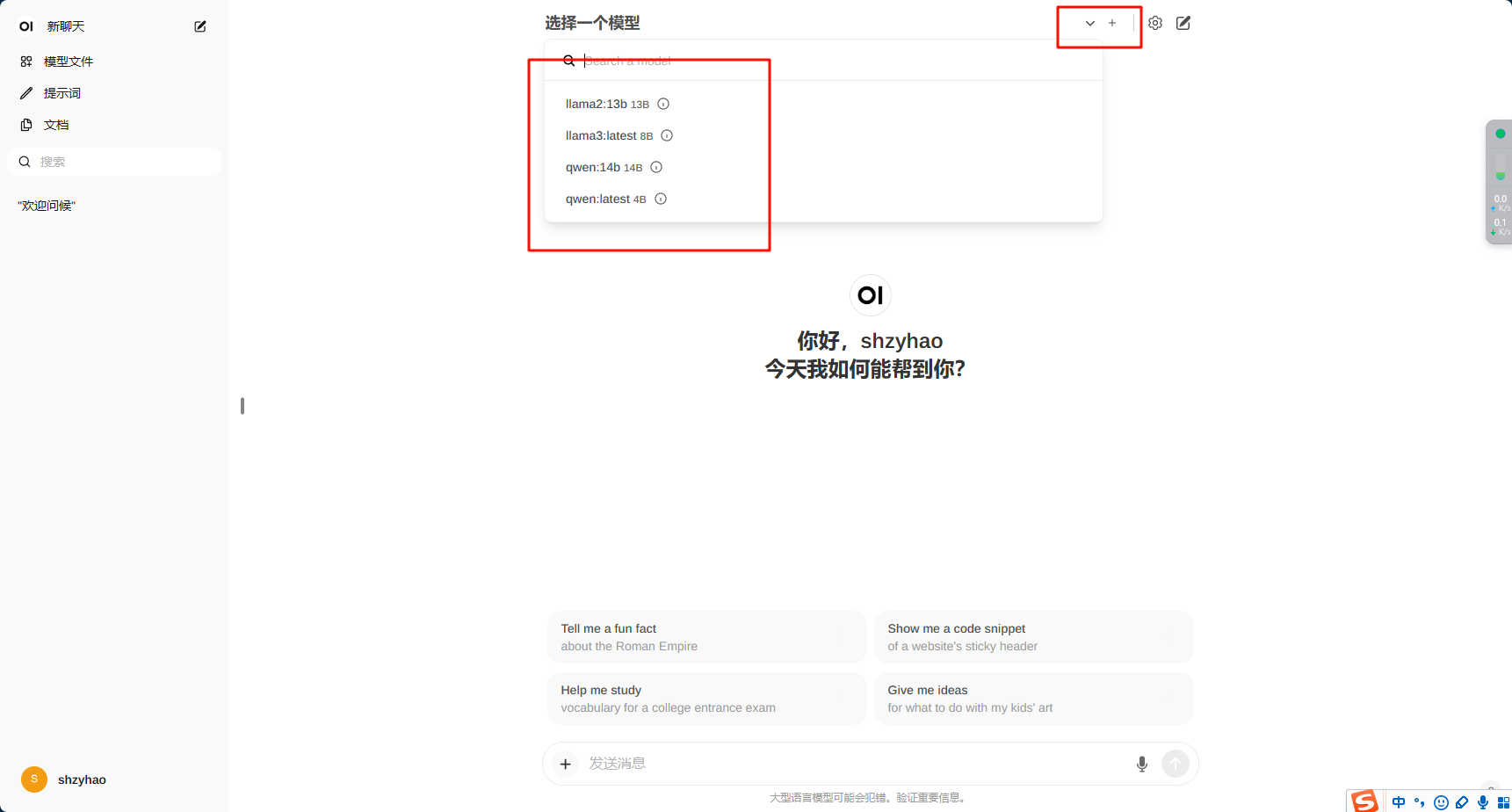

在下拉框中选择一个模型,您下载的 Ollama 的模型都会显示其中。

此时便可以开始问答环节了。

热门资讯