我们提供安全,免费的手游软件下载!

概要

现代基于深度学习的模型在语音增强任务方面取得了显著的性能改进。然而,最先进模型的参数数量往往太大,无法部署在现实世界应用的设备上。为此,我们提出了微小递归U-Net(TRU-Net),这是一种轻量级的在线推理模型,与当前最先进的模型的性能相匹配。TRU-Net的量化版本的大小为362千字节,足够小,可以部署在边缘设备上。此外,我们将小型模型与一种称为相位感知β-sigmoid掩模的新掩模方法相结合,该方法能够同时去噪和去混响。客观和主观评估的结果都表明,我们的模型可以在基准数据集上使用更少数量级的参数,实现与当前最先进模型的竞争性能。

在本文中,我们专注于为现实世界的应用开发一个基于深度学习的语音增强模型,该模型符合以下标准:1。一个小而快速的模型,可以尽可能减少单帧实时因子(RTF),同时保持与最先进的深度学习网络的竞争性能,2。一个可以同时执行去噪和去混响的模型。为了解决第一个问题,我们的目标是改进一种流行的神经架构U-Net[1],该架构已被证明在语音增强任务上具有优越的性能[2,3,4]。先前在源分离应用中使用U-Net的方法不仅在频率轴上而且在时间轴上应用卷积核。U-Net的这种非因果性质增加了计算复杂性,因为需要对过去和未来的帧进行额外的计算来推断当前帧。因此,它不适合于需要实时处理当前帧的在线推理场景。此外,时间轴核使网络计算效率低下,因为在U-Net的编码和解码路径中,相邻帧之间存在冗余计算。为了解决这个问题,我们提出了一种新的神经结构,即微小递归U-Net(TRU-Net),它适用于在线语音增强。该架构旨在实现频率轴和时间轴计算的有效解耦,这使得网络足够快,可以实时处理单个帧。所提出的网络的参数数量仅为0.38(M),足够小,不仅可以在笔记本电脑上,还可以在移动设备上,甚至可以在结合量化技术的嵌入式设备上部署模型[5]。TRU-Net的详细信息将在第2节中详细介绍。接下来,为了同时抑制噪声和混响,我们提出了一种相位感知的β-S形掩模(PHM)。所提出的PHM在没有先前poi的情况下使用标准卷积运算,其灵感来自[6],其中作者提出通过从三角角度重用估计的幅度掩码值来估计相位。PHM与[6]中的方法之间的主要区别在于,PHM被设计为尊重混合物、目标源和剩余部分之间的三角关系,因此估计的目标源和其余部分的总和总是等于混合物。我们通过同时产生两个不同的PHM,将这一性质扩展到四边形,这使我们能够有效地处理去噪和去混响。我们将在第3节中进一步详细讨论PHM。

声谱图可能是许多语音增强模型中最流行的输入特征。每通道能量归一化(PCEN)[7]将动态范围压缩和自动增益控制结合在一起,当应用于频谱图时,这降低了前景响度的变化并抑制了背景噪声[8]。PCEN也适用于在线推理场景,因为它包括时间积分步骤,该步骤本质上是一个仅依赖于先前输入帧的一阶无限脉冲响应滤波器。在这项工作中,我们使用了PCEN的可训练版本。

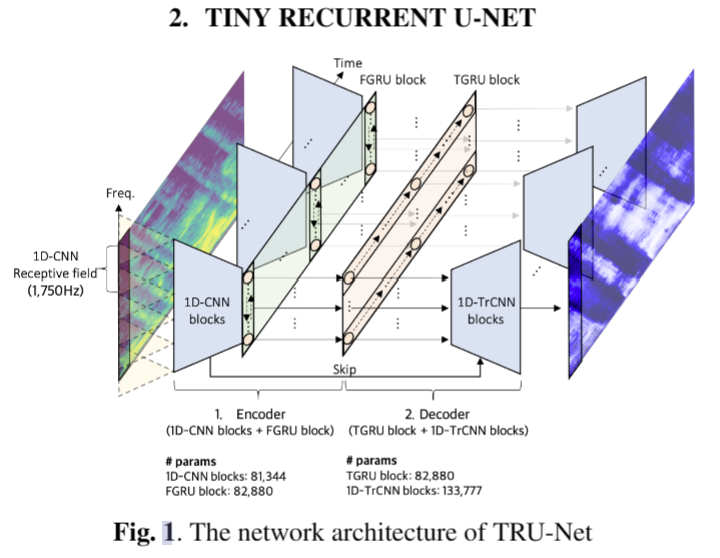

神经网络架构

TRU-Net基于U-Net架构,只是卷积内核不跨越时间轴。因此,它可以被认为是一个在瓶颈层具有1D卷积神经网络(CNNs)和递归神经网络的频率轴U-Net。编码器由1D卷积神经网络(1DCNN)块和频率轴门控递归单元(FGRU)块组成。每个1D-CNN块是类似于[9]的逐点卷积和深度卷积的序列,除了第一层使用标准卷积运算,而不使用前面的逐点卷积。为了节省网络大小,我们使用了六个1D-CNN块,这些块使用跨步卷积将频率轴大小从256降采样到16。这导致小的感受野(1750Hz),这可能对网络性能不利。为了增加感受野,我们沿着频率轴使用双向GRU层[10],而不是堆叠更多的1D-CNN块。也就是说,来自1D-CNN块的16个矢量的序列被传递到双向GRU中,以增加感受野并沿着频率轴共享信息。我们将这个频率轴双向GRU层称为FGRU层。在FGRU层之后使用逐点卷积、批处理归一化(BN)和校正线性单元(ReLU),构成FGRU块。我们为每个前向和后向FGRU小区使用了64个隐藏维度。

解码器由时间轴门控递归单元(TGRU)块和1D转置卷积神经网络(1D TrCNN)块组成。编码器的输出被传递到单向GRU层,以沿着时间轴聚合信息。我们将这个GRU层称为TGRU层。虽然可以将不同的GRU单元应用于编码器输出的每个频率轴索引,但我们在每个频率轴索引来共享相同的单元,以节省参数的数量。逐点卷积、BN和ReLU遵循TGRU层,构成TGRU块。我们为TGRU单元使用了128个隐藏维度。最后,1D TrCNN块用于将TGRU块的输出上采样到原始谱图大小。1D TrCNN块接受两个输入-1。前一层输出2。来自相同层次结构的编码器的跳过张量,并按如下方式对其进行上采样。首先,将两个输入连接并投影到较小的通道大小(256→ 64)。然后,使用1D转置卷积来对压缩信息进行上采样。与通常的U-Net实现相比,该过程节省了参数数量和计算量,在U-Net实现中,两个输入被级联并立即使用转置卷积运算进行上采样。注意,我们没有对1D TrCNN块使用深度卷积,因为我们根据经验观察到,当在解码阶段使用时,它会显著降低性能。编码器和解码器中使用的每个卷积运算之后都是BN和ReLU。

相位感知β-S形掩模

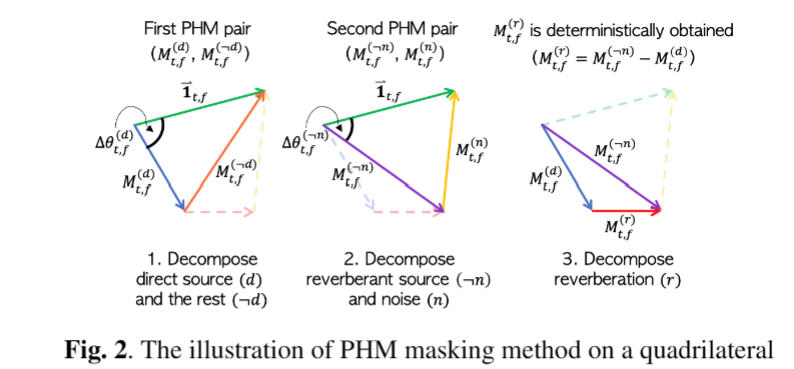

所提出的相位感知β-S形掩模(PHM)是一种复值掩模,能够系统地将估计复数值的总和限制为混合物的值,Xt,f=Y(k)t,f+Y(-k)t,f。PHM将STFT域中的混合物Xt,f分为两部分,作为一对一的方法,即信号Y(k)t,f和信号Y(-k)t的其余部分之和,f=Xt,f-Y(k,t,f,其中indexk可以是直接路径源(d)、混响(r)和噪声(n)之一,在我们的设置中,k∈{d,r,n}。复值maskM(k)t,f∈C估计感兴趣的源k的幅度和相位值。

计算PHM需要两个步骤。首先,网络输出两个掩码|M(k)t,f|和|M(-kφ是最后一层之前的网络层组成的函数|M(k)t,f|用作估计源k的幅度掩码,其值范围从0到βt,f。βt,f的作用是设计一个接近最优值的掩码,该掩码具有灵活的幅度范围,从而使值不受0和1之间的限制,这与常用的S形掩码不同。此外,由于复值掩码M(k)t,f和M(-k)t,fms的和必须组成一个三角形,因此设计一个满足三角形不等式的掩码是合理的,即|M(k,t,f|+|M(-k)t,f|≥1和|||M(k-t,f |−|M(.k)t、f||||||≤1。为了解决第一个不等式,我们设计了从最后一层输出βt,f的网络,具有如下的softplus激活函数,βt,f=1+softplus((ψβ(φ))t,f),其中ψβ表示输出βt、f的额外网络层。第二个不等式可以通过将βt,f的上界裁剪1/|σ(k)(zt,f)−σ(-k)(zt,f)|来满足。

一旦确定了幅度掩模,我们就可以构造相位掩模ejθ(k)t,f。给定三角形三边的大小,我们可以计算混合物和源k之间的绝对相位差∆θ(k)t,f的余弦,如下所示,cos(∆θ。然后,相位掩模的相位校正旋转方向ξt,f∈{1,−1}(顺时针或逆时针)估计如下,ejθ(k)t,f=cos(∆θ(k)t,f)+jξt、f sin(∆。使用两类直通Gumbel softmax估计量来估计ξt,f[11]。M(k)t,f定义如下,M(k。最后,M(k)t,f与Xt,f相乘,以如下估计源k。

执行的细节

由于我们的目标是执行去噪和去混响,我们使用热声学[20]来模拟具有随机采样吸收、房间大小、源位置和麦克风距离的人工混响。我们使用了2秒的语音和噪声片段,并将它们与范围从-5 dB到25 dB的均匀分布的源噪声比(SNR)混合。输入特征被用作对数幅度谱图、PCEN谱图和解调相位的实部/虚部的信道级联。我们使用了AdamW优化器[21],当验证分数连续三个时期没有提高时,学习率减半。初始学习率设置为0.0004。窗口大小和跳变大小分别设置为512(32毫秒)和128(8毫秒)。我们还将所提出的模型量化为INT8格式,并将模型大小与先前的工作进行了比较。我们的量化模型实验的目的是减少嵌入式环境的模型大小和计算成本。我们采用了[5]中提出的使用量化数的计算流程来量化神经网络。此外,为了高效的硬件实现,我们采用了均匀对称量化方案[22],该方案使用均匀量化并将零点限制为0。在实验中,使用量化的权重、激活和输入来处理神经网络中的所有层;只有偏置值以全精度表示。以全精度计算诸如特征提取和掩蔽之类的其他处理步骤。对于编码器和解码器层,我们在训练期间观察中间张量的尺度统计。然后,在推理过程中,我们使用观察到的最小值和最大值的平均值来固定激活的尺度。由于每个时间步长的内部激活的大动态范围,在推理时间期间只有GRU层被动态量化。

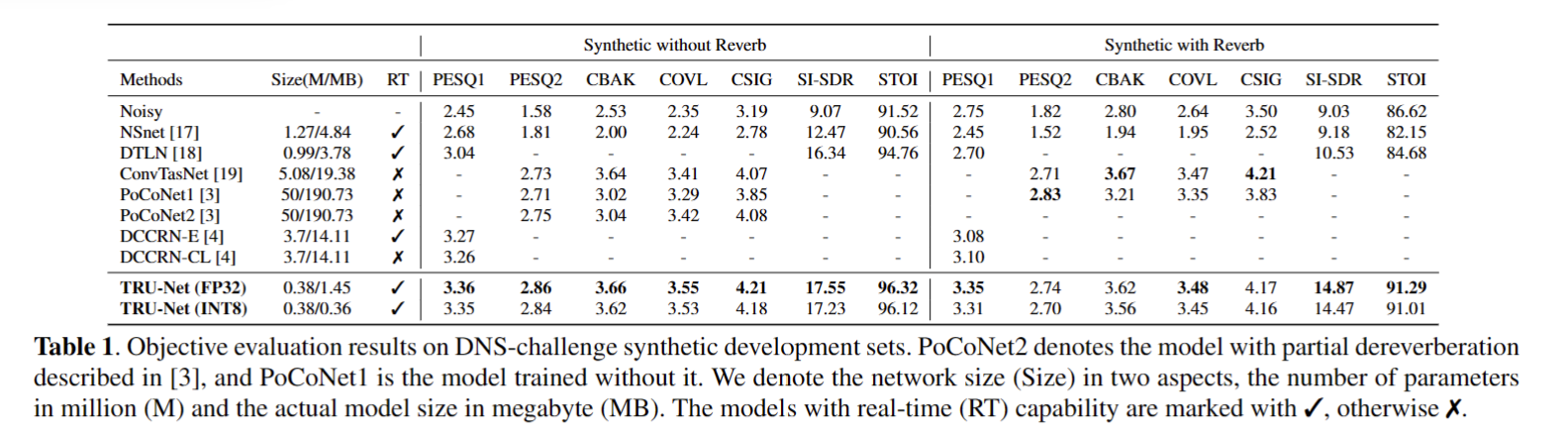

我们通过在大规模DNS挑战数据集[25]和内部收集的数据集上训练模型,进一步检查了模型的去噪性能。它在两个非盲DNS开发集上进行了测试,1)无混响的合成剪辑(合成无混响)和2)有混响的合成片段(合成有混响)。我们将我们的模型与最近提交给2020年Interspeech DNS挑战的模型[3,4,17,18,19]进行了比较。6个评估指标,PESQ、CBAK、COVL、CSIG、SI-SDR和STOI[26,27,28,29]。注意,尽管建议使用ITU-T P862.2宽带版本的PESQ(PESQ2),但一些研究报告了使用ITU-T P762.1(PESQ1)的得分。因此,我们使用了两个PESQ版本来将我们的模型与其他模型进行比较。结果如表1所示。我们可以看到,TRU-Net在Synthetic without Reverb集合中显示出最佳性能,同时具有最小数量的参数。在Synthetic with Reverb集合中,TRU-Net使用的参数比其他模型少几个数量级,显示出有竞争力的性能。

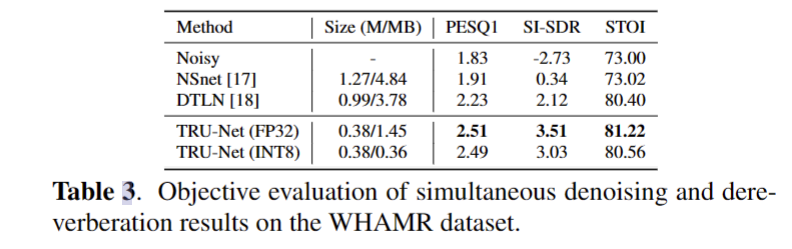

在包含3000个音频文件的WHAMR数据集的最小子集上测试了同时去噪和去混响的性能。WHAMR数据集由噪声混响混合物和作为地面实况的直接源组成。表1中的TRU-Net模型(FP32和INT8)用于测试。我们在表3中展示了我们的模型的去噪和去混响性能,以及在同一WHAMR数据集上测试的另外两个模型。与其他基线模型相比,我们的模型获得了最好的结果,这表明了TRU-Net在同时去噪和去混响任务上的参数效率。

热门资讯